Einfach erklärt: Prävalenzfehler und Fluggastdaten (PNR)

Der Prävalenzfehler (engl. „base rate fallacy“) ist die Tendenz, die Häufigkeit im Basisdatensatz (Prävalenz) bei Vorliegen spezifischer, individueller Informationen zu ignorieren. Anstatt allgemeine Informationen und Statistiken mit Informationen über einen einzelnen Fall zu integrieren, neigt der Verstand dazu, erstere zu ignorieren und sich auf letztere zu konzentrieren. Dieses Phänomen ist weit verbreitet - und trifft auch ausgebildete Statistiker, schreibt der amerikanisch-israelische Psychologe Daniel Kahneman in seinem Buch „Schnelles Denken, langsames Denken“. Er veranschaulicht diesen häufigen Argumentationsfehler schon früh im Buch mit folgendem Beispiel. Kahneman schreibt:

Eine Person wurde von einem Nachbarn wie folgt beschrieben: Steve ist sehr schüchtern und zurückgezogen, immer hilfsbereit, aber mit wenig Interesse an Menschen oder der realen Welt. Als bescheidener und ordentlicher Mensch hat er ein Bedürfnis nach Ordnung und Struktur und eine Leidenschaft für Details. Ist es wahrscheinlicher, dass Steve ein Bibliothekar oder ein Landwirt ist?

Du bist wie die meisten Menschen, wenn deine intuitive Antwort auf diese Frage war, dass Steve eher ein Bibliothekar ist. Wie Kahneman schreibt: "Die Ähnlichkeit von Steves Persönlichkeit mit der eines stereotypen Bibliothekars fällt fast allen sofort auf"; die Tatsache, dass es in den Vereinigten Staaten "mehr als 20 männliche Bauern pro männlichem Bibliothekar" gibt, wird in unseren Berechnungen jedoch fast immer vernachlässigt (S. 7).

Eine Art von Prävalenzfehler ist das Paradoxon der Falsch-Positiven, in dem falsch-positive Ergebnisse wahrscheinlicher sind als wahr-positive Ergebnisse. Dies tritt auf, wenn die Bevölkerung insgesamt eine geringe Häufigkeit einer bestimmten Eigenschaft aufweist und die tatsächliche Häufigkeit niedriger ist als die Rate der Falsch-Positiven. Dies könnte wider Erwarten sein, aber betrachte das folgende Beispiel:

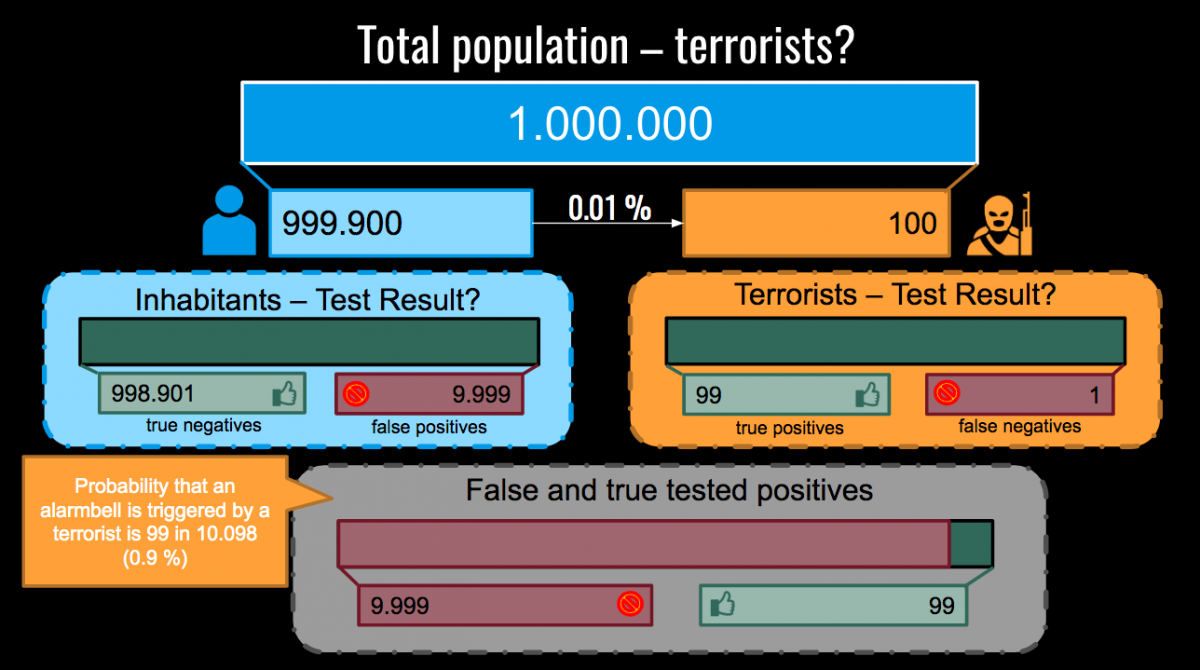

Eine Stadt mit 1.000.000 EinwohnerInnen führt Überwachungsmaßnahmen ein, um TerroristInnen zu erwischen. Dieses spezielle Überwachungssystem hat eine Fehlerrate von 1%, was bedeutet, dass 1. wenn einE TerroristIn entdeckt wird, das System sie oder ihn in 99% der Fälle als Treffer registriert und in 1% der Fälle nicht und 2. wenn einE Nicht-TerroristIn entdeckt wird, das System sie oder ihn in 99% der Fälle nicht markiert, und 1% der Fälle schon. Wie hoch ist die Wahrscheinlichkeit, dass eine von diesem System gekennzeichnete Person einE TerroristIn ist?

Macht man nun den Prävalenzfehler, würde man antworten, dass es eine 99%ige Chance gibt, dass diese Person einE TerroristIn ist. Auf den ersten blick, scheint diese Vorhersage bei einer Fehlerrate des Systems von 1% sinnvoll zu sein; dies ist jedoch ein Beispiel für eine falsche Schlussfolderung, da die Fehlerrate der Treffererkennung nicht berücksichtigt wurde. Die Dekonstruktion des Paradoxons der Falsch-Positiven zeigt, dass die wahre Chance, dass diese Person einE TerroristIn ist, näher bei 1% als bei 99% liegt.

Dieses Bild (von Ali Al-Awadi) veranschaulicht, wie das Paradoxon der Falsch-Positiven funktioniert: Wir nehmen an, dass es bei einer Million EinwohnerInnen 999.900 gesetzestreue BürgerInnen und 100 TerroristInnen gibt. Die Anzahl der wahren Positiven, die von den Überwachung der Stadt registriert wurde, beträgt 99, die Anzahl der falschen Positiven liegt bei 9.999 - eine Zahl, die selbst das beste System überfordern würde. Insgesamt 10.098 Menschen - 9.999 Nicht-TerroristInnen und 99 tatsächliche TerroristInnen - werden das System auslösen. Das bedeutet, dass aufgrund der hohen Anzahl von False Positives die Wahrscheinlichkeit, dass das System einen Terroristen oder eine Terroristin registriert, nicht 99% beträgt, sondern unter 1% liegt. Die Suche in großen Datensätzen nach wenigen Verdächtigen bedeutet, dass nur eine geringe Anzahl von Treffern jemals korrekt sein wird. Dies ist ein hartnäckiges mathematisches Problem, das sich auch bei verbesserter Genauigkeit nicht vermeiden lässt.

Dieses hypothetische, ineffektive Überwachungssystem kann mit den realen Systemen verglichen werden, die das Leben der heutigen EuropäerInnen bestimmen. Ein solches Beispiel ist die Massenspeicherung von Passagierdaten in der EU. In den Vereinigten Staaten wurde die Aufbewahrung von Fluggastdatensätzen (PNR) nach den Terroranschlägen von 2001 in New York City eingeführt. Obwohl sie in Europa auf den Widerstand der Zivilgesellschaft und liberaler PolitikerInnen stieß, wurde die PNR-Richtlinie nach fünfjährigen Verhandlungen 2016 von den EU-Mitgliedstaaten verabschiedet. Die Erfassung dieser Daten zielt auf die Verhütung, Aufdeckung, Ermittlung und Verfolgung von terroristischen Straftaten und schweren Verbrechen ab.

In Österreich verarbeitet die Fluggastdatenzentralstelle (Passenger Information Unit - PIU) seit März 2019 PNR-Daten. Diese Woche hat die Fluggastdatenzentralstelle eine Antwort auf eine parlamentarische Anfrage zur Umsetzung der PNR-Richtlinie in Österreich gegeben. Demnach wurden von Februar 2019 bis zum 14. Mai 7.633.867 Datensätze an die Stelle übermittelt. Im Durchschnitt werden pro Tag etwa 490 Zugriffe gemeldet, wobei durchschnittlich etwa 3.430 Zugriffe pro Woche einer weiteren Überprüfung bedürfen. Unter den 7.633.867 bisher verarbeiteten Datensätzen waren 51 bestätigte Treffer und in 30 Fällen wurden auf dem betreffenden Flughafen infolgedessen Maßnahmen gesetzt.

Was diese kleine Erfolgsgeschichte jedoch nicht erfasst, ist der Schaden, der den Tausenden von unschuldigen PassagierInnen zugefügt wird, die zu Unrecht vom System markiert werden und die polizeilichen Ermittlungen oder der Verweigerung der Einreise in Bestimmungsländer ohne triftigen Grund ausgesetzt sind. Wie im obigen hypothetischen Beispiel ist Massenüberwachung, mittels derer ein kleiner, ausgewählter Teil der Bevölkerung gesucht wird, invasiv, ineffizient und verletzt unsere Grundrechte. Sie unterwirft die Mehrheit der Menschen extremen Sicherheitsmaßnahmen, die nicht nur unwirksam sind, um TerroristInnen und Kriminelle zu fangen, sondern auch das Recht auf Achtung der Privatsphäre untergraben und immense Schäden verursachen können.

Sicherheit und Privatsphäre sind nicht unvereinbar - vielmehr sollte es es ein notwendiges Gleichgewicht, das von einer Gesellschaft bestimmt werden muss, geben. Das PNR-System stellt durch die Verwendung fehlerhafter mathematischer Annahmen sicher, dass weder Sicherheit noch Privatsphäre geschützt sind.

Lies hier und hier mehr über PNR und informiere dich über unsere Zusammenarbeit mit der Gesellschaft für Freiheitsrechte e.V. (GFF), um diese Vorratsdatenspeicherung zu kippen.

Übersetzt aus dem Englischen. Original von Kaitlin McDermott.

Da du hier bist!

… haben wir eine Bitte an dich. Für Artikel wie diesen analysieren wir Gesetzestexte, bewerten Regierungsdokumente oder lesen Allgemeine Geschäftsbedingungen (wirklich!). Wir sorgen dafür, dass möglichst viele Menschen sich mit komplizierten juristischen und technischen Inhalten befassen und auch verstehen, dass sie große Auswirkungen auf unser Leben haben. Diese Arbeit machen wir aus der festen Überzeugung, dass wir gemeinsam stärker sind als alle Lobbyisten, Machthabende und Konzerne. Dafür brauchen wir deine Unterstützung. Hilf uns, eine starke Stimme für die Zivilgesellschaft zu sein!

Jetzt Fördermitglied werden